10 de septiembre de 2020 |

REVISTA UNIVERSIDAD EAFIT - INDUSTRIAS 4.0 Y TECNOLOGÍAS CONVERGENTES

En medio de la avalancha de datos que se producen todos los días en internet, una de las mayores unidades para el almacenamiento de información hasta

ahora conocidas es el Zettabyte (ZB). Equivale a mil trillones de bits, la unidad mínima empleada en informática.

Su capacidad es tal que en un ZB se podrían alojar más de 17 mil millones de iPhone de 64 gigas y una película en alta definición duraría cerca de 36 millones de años. Para el año 2021 se pronostica que el tráfico de los centros de datos en el planeta, gran parte almacenados en la nube computacional, podría superar los 20 ZB anuales, más del doble del peso actual de la red mundial.

Firmas internacionales como Cisco, líder en transformación digital y estudio de big data, han visualizado este panorama en la producción de información en su Índice Global de la Nube.

En este mar de datos, literalmente, navegan los data scientist que son profesionales en áreas convergentes como matemática, modelación, estadística y computación dedicados a auscultar la inmensidad de datos producidos a diario. Por medio de técnicas de data mining hallan información valiosa que sirve para tomar mejores decisiones tanto en el sector privado como en políticas públicas.

Son los científicos de la era de la información que se dedican a pensar, principalmente desde la ingeniería y la abstracción matemática, aplicaciones para hurgar en los recovecos del big data y crear algoritmos que solucionen problemas que afectan la cotidianidad desde el sector financiero hasta el medioambiente.

Edwin Montoya Múnera es ingeniero de sistemas y doctor en Telecomunicaciones de la Universidad Politécnica de Valencia (España). En la actualidad es profesor investigador de EAFIT y coordinador del Centro de Excelencia y Apropiación en Big Data y Data Analytics de la Alianza Caoba, una iniciativa público-privada impulsada por el Gobierno Nacional para promover investigación aplicada en estas áreas. La iniciativa opera desde el año 2016 en el cuarto piso del bloque 18 de EAFIT

“La ciencia de datos necesita de dos grandes insumos: uno son los grandes datos, lo segundo es la infraestructura para procesarlos. La Universidad cuenta con infraestructura tecnológica de alto nivel, desde el supercomputador Apolo hasta servidores intermediarios en el Laboratorio de Sistemas, que hemos usado para procesar los datos masivos”, comenta Edwin Montoya, quien es además jefe del Departamento de Ingeniería de Sistemas de la Universidad y líder de Caoba.".

Los datos, el nuevo petróleo

La minería de datos, una de las técnicas para la extracción de información y conocimiento a partir del big data, se popularizó durante la década de 1990 con la masificación de las redes informáticas. El término se refiere al data analytics fundamentado en métodos estadísticos y de aprendizaje computacional como el machine learning, técnicas que se perfeccionan con el avance tecnológico.

Para el coordinador del Centro de Excelencia Caoba, durante los cinco años en que se ha establecido la plataforma se han generado distintas soluciones mediante la investigación aplicada, consultoría, formación y transferencia de conocimiento en estos campos, contribuyendo a la competitividad del país.

“El análisis de datos es una tecnología relativamente vieja, es decir, tiene más de 20 años en los cuales las empresas ya hacían analítica”, recuerda Montoya. “Las fuentes de datos eran los mismos datos de las compañías y no se habían desarrollado modelos tan sofisticados de computación que permitieran sacarles más provecho. Con el aumento del procesamiento y la mayor diversidad de generación hubo una explosión de datos”, complementa.

Este fenómeno ha venido creciendo de manera exponencial en la última década. En la actualidad, un gran volumen de big data se produce a diario de manera frenética: correos electrónicos, transacciones bancarias, interacciones en redes sociales, fotos, trinos, audios y sensores de vehículos y satélites, entre otros dispositivos, transmiten en forma continua data apreciable para organizaciones públicas y privadas.

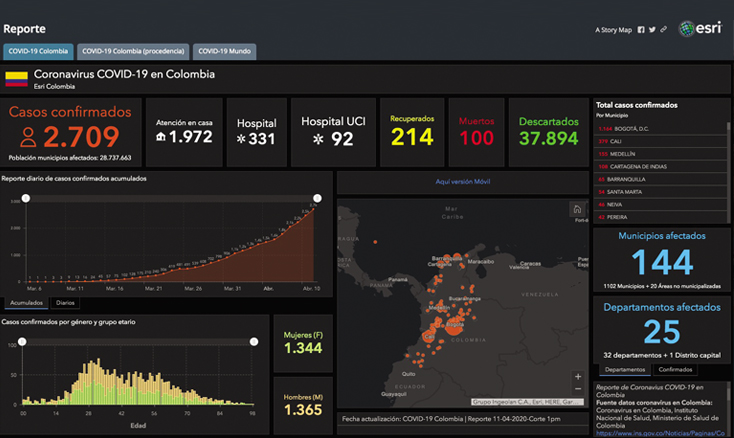

La pandemia del COVID-19 ha sido monitoreada gracias a la transmisión continua de abundante data desde todos los países

“Algo muy importante ha sido la democratización de los datos. Una de

las iniciativas del Centro Caoba ha sido que estas disciplinas no sean conocidas solo por personas avanzadas en matemáticas, sino por cualquiera cercano a los datos”, comenta la magíster en ingeniería Silvia María Lozano Argel, investigadora del Centro de Excelencia, quien trabaja en la consolidación de una comunidad de datos en el país.

Olga Lucía Quintero Montoya, doctora en Ingeniería de Sistemas de Control de la Universidad Nacional de San Juan (Argentina), fue una de las gestoras de Caoba desde el Departamento de Ciencias Matemáticas de EAFIT.

Como experta en asimilación de datos e inteligencia artificial ha aplicado su conocimiento a la solución de distintos problemas.

En la actualidad, con la cooperación del Grupo de Investigación de Matemáticas y Física del Departamento de Matemática Aplicada en TU Delft (Países Bajos), apoya a estudiantes de doctorado en sus avances.

“El mundo real tiene dinámicas no lineales y a veces hay fenómenos que suceden que no son gaussianos –explica–. Las técnicas matemáticas aplicadas para la construcción de modelos, a partir de los datos, constituyen un área que viene desde la teoría de control y sistemas que se llama identificación de sistemas dinámicos. De ahí nació la inteligencia artificial, construir modelos que se acerquen a la manera en que los humanos razonan. Un científico de datos debe conocer la ley de los grandes números y la probabilidad para poder entender esas relaciones”.